Google AI bắt nữ nhân viên da đen nghỉ việc, vấn đề mà tất cả các công ty công nghệ sẽ phải đối mặt

Với sự phát triển nhanh chóng của ngành công nghiệp AI trên toàn thế giới, các vụ việc thiên vị thuật toán đã làm căng thẳng bê bối phân biệt chủng tộc và màu da.

Vào ngày 20/2, Meg Mitchell, trưởng nhóm Ethical Artificial Intelligence (trí tuệ nhân tạo đạo đức) của Google, đã đăng một tuyên bố ngắn trên Twitter: “Tôi bị sa thải”, giống hệt như những gì đã xảy ra với Timnit Gebru, một nhà nghiên cứu nữ khác vào năm ngoái. Hai người phụ nữ là hai cựu đồng trưởng bộ phận Ethical AI của Google.

Vào cuối năm ngoái, Gebru đã tweet rằng cô ấy đã bị đuổi khỏi công ty. Sau khi từ chối rút lại bài báo nghiên cứu chỉ trích công nghệ AI của Google, cô ấy đã bày tỏ sự không hài lòng với định kiến chủng tộc của công ty trong một email nội bộ và đã bị sa thải. Từ góc độ bên ngoài, khó có thể bỏ qua mối liên kết việc Mitchell bị sa thải với vụ Gebru.

1. Các câu chuyện trên Twitter

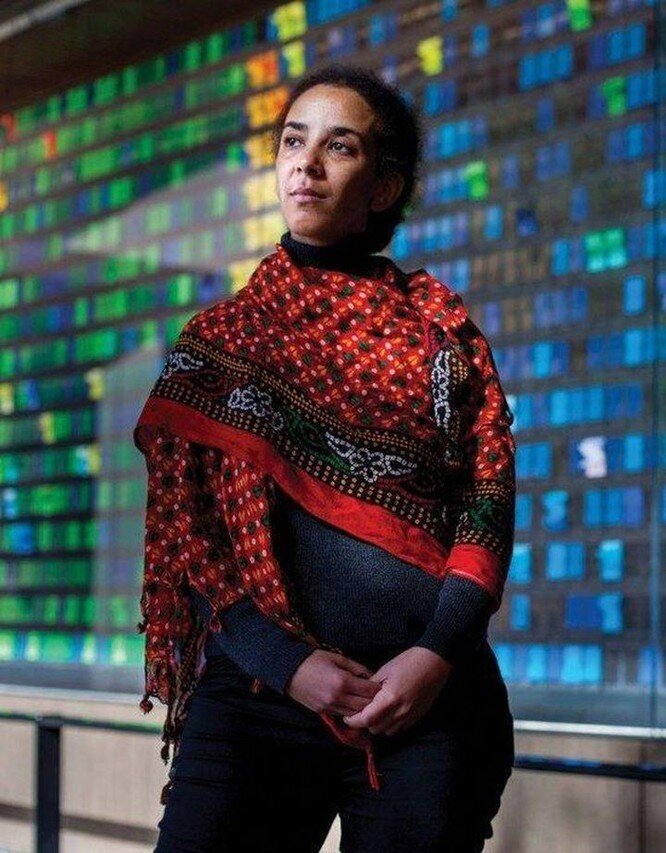

Gebru là đồng trưởng bộ phận Ethical AI của Google và là một trong số rất ít các nhà nghiên cứu nữ da đen trong Google (theo báo cáo hàng năm năm 2020 của công ty, 3,7% nhân viên của Google là người da đen), đồng thời, cô cũng là đồng sáng lập của Black In AI, nền tảng dành riêng cho quyền bình đẳng cho người da đen trong lĩnh vực thuật toán.

Về phía Google, Jeff Dean, người đứng đầu bộ phận AI của Google đã lên tiếng và nói rằng "bài báo không đáp ứng các tiêu chuẩn xuất bản. Gebru đã chủ động từ chức". Hai bên có ý kiến bất đồng và họ đã đấu khẩu qua lại trên Twitter. Sau vụ việc, hầu hết cộng đồng AI đều đứng về phía Gebru.

Theo báo cáo của BBC, hơn 4.500 nhà nghiên cứu từ Microsoft, Google và các công ty lớn khác đã ký một bức thư ngỏ ủng hộ Gebru, yêu cầu Google giải thích thêm về lý do sa thải Gebru. Vào tháng 1 năm nay, các nhân viên nội bộ của Google cũng đã thành lập Liên đoàn AIphabet, mở rộng cho tất cả nhân viên AIphabet, bao gồm cả công nhân tạm thời, nhà cung cấp, v.v., lên tiếng vì quyền lợi của thiểu số và yêu cầu khôi phục vị trí của Gebru.

Giám đốc điều hành của công ty Pichai đã đứng ra để xoa dịu tình hình và hứa sẽ tiến hành các cuộc điều tra sâu hơn để chấm dứt vụ việc này. Vào tháng 2 năm nay, Dean cũng đã xin lỗi về việc Gebru bị sa thải và những tổn hại gây ra cho các nhân viên nữ khác. Google cũng đã công bố một chính sách đa dạng mới, bao gồm việc liên kết mục tiêu DEI (Đa dạng, Công bằng và Hòa nhập) với đánh giá hiệu suất của nhân viên.

Đây dường như là một hành động dập lửa tiếp theo, nhưng sau đó Meg Mitchell lại bị sa thải. Mitchell cũng là một chuyên gia tại Ethical AI. Cô ấy nghiên cứu về sự thiên vị máy móc, sự đa dạng về sắc tộc và giới tính cũng như các mô hình ngôn ngữ để chụp ảnh. Mitchell và Gebru đồng lãnh đạo nhóm Ethical AI của công ty. Đồng thời, điều đáng chú ý là cô ấy cũng là đồng tác giả của bài báo châm ngòi đó.

Sau khi Gebru bị sa thải, Mitchell liên tục bày tỏ sự không hài lòng với Google trên các nền tảng công khai. Vào tháng 1 năm nay, cô đã bị hạn chế quyền truy cập vào e-mail nội bộ của công ty. Chỉ vài giờ trước khi bị sa thải, Mitchell cũng chỉ trích Google trên Twitter vì "luôn xa lánh phụ nữ da đen".

Phản hồi của Google đối với việc sa thải Mitchell là "Sau khi tiến hành xem xét hành vi của người quản lý này, chúng tôi đã xác nhận rằng có nhiều vi phạm quy tắc ứng xử cũng như các chính sách bảo mật của chúng tôi, bao gồm việc lấy cắp các tài liệu bí mật nhạy cảm với doanh nghiệp và dữ liệu riêng tư của các nhân viên khác."

2. Thuật toán thiên vị

Quay trở lại bài báo nghiên cứu gây tranh cãi ban đầu "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?" (Tạm dịch: Nguy cơ của những con vẹt ngẫu nhiên: Liệu mô hình ngôn ngữ có quá lớn). Bài nghiên cứu khám phá những rủi ro của việc tiêu thụ điện năng cao do các mô hình ngôn ngữ lớn (chẳng hạn như BERT) từ quan điểm bảo vệ môi trường, chủng tộc và giới tính. Đồng thời, Gebru chỉ ra rằng nếu dữ liệu hiện có bị sử dụng bừa bãi để đào tạo trí tuệ nhân tạo, nó sẽ càng làm sâu sắc thêm định kiến của các nhóm thiểu số bên lề về mô hình ngôn ngữ AI.

Phần giới thiệu của bài báo có nội dung: “Chúng tôi tự hỏi liệu chúng tôi đã suy nghĩ thấu đáo về những rủi ro tiềm ẩn liên quan đến việc phát triển thuật toán này và các chiến lược để giảm thiểu những rủi ro này hay chưa.”

Google AI lần đầu tiên phát minh ra mô hình ngôn ngữ Transformer vào năm 2017 và vào năm 2018, thuật toán BERT - mô hình ngôn ngữ được đưa ra trên cơ sở này đã gây được tiếng vang trong lĩnh vực trí tuệ nhân tạo, đồng thời cũng được sử dụng rộng rãi trong việc đào tạo công cụ tìm kiếm của Google và trở thành một nguồn thu nhập kinh tế quan trọng của Google.

Bài báo này là mối quan tâm về nghiên cứu AI, và mối quan tâm này không phải là không có căn cứ. Đây không phải là lần đầu tiên xuất hiện định kiến đạo đức liên quan đến AI.

Vào năm 2015, Google Photos đã dán nhãn hai người da ngăm đen là "khỉ đột". Google hứa sẽ "thực hiện các biện pháp ngay lập tức" để ngăn chặn những sai lầm lặp lại. Nhưng sau đó để giải quyết vấn đề này, Google đã trực tiếp xóa nhãn của cụm từ này khỏi kết quả tìm kiếm. Tạp chí Wired đã thử nghiệm hơn 40.000 bức ảnh động vật trên Google Photos và cuối cùng đưa ra kết luận: Google không còn dán nhãn bất kỳ bức ảnh nào là khỉ đột, tinh tinh, khỉ, thậm chí là ảnh của những động vật như vậy.

Năm ngoái, sai lệch về AI gây sốc nhất là thuật toán PULSE xác định Obama là người da trắng. Thuật toán do Nvidia phát triển này sử dụng một công nghệ gọi là "nâng cấp" để xử lý dữ liệu hình ảnh nhằm tạo ra hình ảnh khuôn mặt có độ phân giải cao mới từ hình ảnh có độ phân giải thấp ban đầu. Kết quả này làm dấy lên tranh cãi về tính phân biệt chủng tộc của AI, sự thiên vị đến từ người tạo ra chúng và dữ liệu mà chúng đang làm việc, trong trường hợp này là chuyển hình ảnh người da màu thành da trắng.

3. Các cuộc xung đột tại trụ sở Google

Nguyên nhân sâu xa về các vấn đề đạo đức của Google AI là những định kiến trong xã hội loài người. Từ lâu, các công ty công nghệ ở Thung lũng Silicon đã thể hiện văn hóa cởi mở và bình đẳng với thế giới bên ngoài. Ngay từ năm 2014, 33 công ty công nghệ ở Thung lũng Silicon đã ký cam kết đa dạng hóa.

Tuy nhiên, bên cạnh sự thiên vị về thuật toán, trong những năm gần đây, các công ty như Microsoft, Amazon và Uber thường xuyên bùng nổ các vụ bê bối đạo đức về phân biệt giới tính và thành kiến về màu da khiến Google, từng là nhà tuyển dụng tốt nhất thế giới, cũng không thể thoát khỏi cuộc chỉ trích.

Năm 2018, theo New York Times, Google đã trả khoảng 90 triệu USD cho Andy Rubin, "cha đẻ của Android" sau khi Andy bị cáo cuộc quấy rối tình dục và phải từ chức. Google còn tiếp tục đầu tư hàng triệu USD cho các dự án mà ông tham gia. Điều này đã gây ra sự phản đối mạnh mẽ từ các nhân viên của Google.

Hơn 20.000 nhân viên tại hơn 20 văn phòng trên khắp thế giới đã đình công tập thể và xuống đường hô hào, "Chúng tôi muốn sự minh bạch, trách nhiệm giải trình và điều chỉnh cơ cấu". Google sau đó đã xin lỗi và hứa sẽ rút lại trọng tài bắt buộc đối với hành vi sai trái có mục tiêu.

Mặc dù nhiều cuộc thảo luận về đạo đức liên quan đến AI liên tục xuất hiện trong Google trong những năm gần đây, thế giới bên ngoài vẫn tiếp tục chỉ trích Google vì đã làm không tốt trong những lĩnh vực này. Nhưng ở một góc độ khác, với sự phát triển nhanh chóng của ngành công nghiệp AI trên toàn cầu, chỉ có Google mới bùng nổ các cuộc thảo luận nghiêm túc trên quy mô lớn như vậy. Điều này chính xác được sinh ra từ văn hóa quản lý tự do và thẳng thắn lâu đời của Google.

Sau cơn bão từ chức của Gebru, không chỉ đội Ethical AI mà bầu không khí của toàn bộ công ty Google tiếp tục căng thẳng. Trong cuộc tranh cãi nảy lửa và nhiều cuộc biểu tình phản đối trong nội bộ Google, Google đã thành lập liên đoàn lao động quy mô lớn đầu tiên ở Thung lũng Silicon, AIphabet Worker Union, cho phép nhân viên tự do phát biểu.

Năm nay, sau nhiều cuộc điều tra sâu, Jeff Dean đã xin lỗi về sự cố Gebru và bổ nhiệm Marian Croak, một giám đốc điều hành người da đen được kính trọng, quản lý Google AI. Mục đích ban đầu của Ethical AI là theo dõi xu hướng đạo đức AI của Google. Do đó, bộ phận này cũng là bộ phận đa dạng nhất trong công ty, tập hợp những nhóm trong thuật toán có nhiều khả năng bị tổn hại bởi định kiến.

Điều đáng chú ý là công đoàn AIphabet đã không dừng lại sau vụ việc này. Vào ngày 11/2, công đoàn AIphabet đã đệ đơn cáo buộc Google không công bằng với lao động, đây là hành động pháp lý đầu tiên của công đoàn. Khác với những hành động trước đây như thư ngỏ, cáo buộc này đã có hiệu lực pháp luật. Đối với một nền công nghệ đầy những hộp đen và ẩn số, vẫn còn rất nhiều vấn đề đáng bàn về AI. Google là công ty đầu tiên có những cuộc thảo luận sôi nổi, nhưng nó sẽ không bao giờ là công ty cuối cùng.

Bạn muốn trở thành VIP/PRO trên 24HMONEY?

Bấm vào đây để liên hệ 24HMoney ngay

Bàn tán về thị trường